Beim Einsatz neuer Technologien sollten Organisationen die Sicherheits- und Compliance-Auswirkungen ernsthaft berücksichtigen. Besonders in Branchen wie Banken und Gesundheitswesen muss gewährleistet werden, dass KI-Systeme sicher und compliant sind.

Eine Möglichkeit, diese Bedenken zu adressieren, besteht darin, ein Open-Source-KI-Modell zu verwenden. Im Gegensatz zu proprietären Systemen wie ChatGPT sind Open-Source-LLMs transparent in Bezug auf ihre Trainingsdaten und zugrunde liegenden Algorithmen (zum Beispiel, wie Daten verarbeitet werden). Darüber hinaus können Open-Source-Modelle innerhalb der eigenen Infrastruktur einer Organisation gehostet werden, was eine grössere Kontrolle und Anpassung ermöglicht. Dies stellt sicher, dass sie den Sicherheits- und Compliance-Anforderungen der Organisation entsprechen.

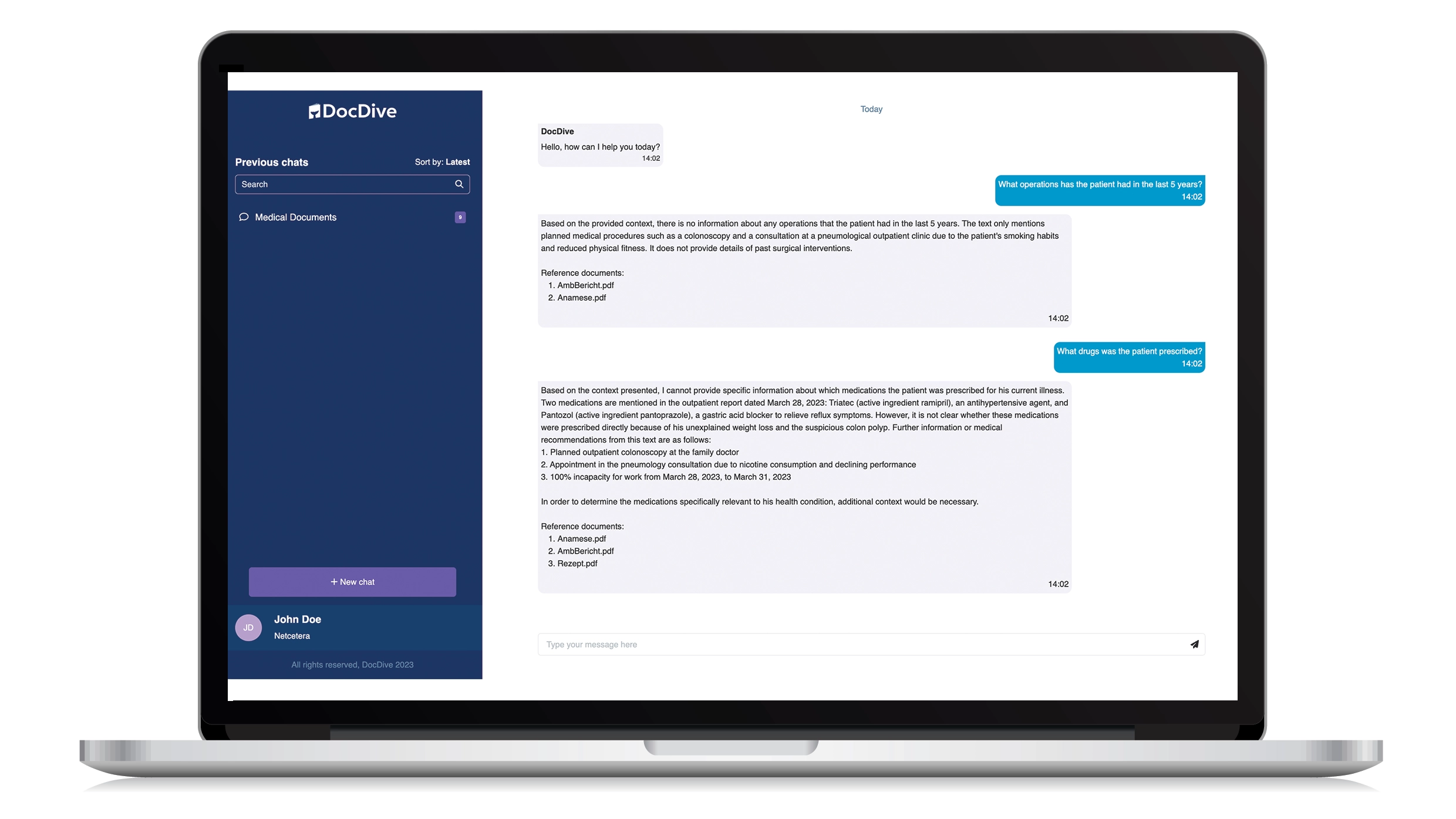

Ein Gesundheitsdienstleister könnte beispielsweise ein Open-Source-LLM verwenden, das auf medizinischen Daten trainiert wurde und es auf seinen eigenen Servern hosten. Dies würde sicherstellen, dass sensible Patientendaten innerhalb des Ökosystems des Anbieters bleiben, das Risiko von Datenverletzungen minimieren und die Einhaltung von Vorschriften wie HIPAA gewährleisten.

Beim Abwägen, ob ein Open-Source- oder proprietäres LLM verwendet werden soll, sollten Organisationen zunächst ihre spezifischen Bedürfnisse und Prioritäten berücksichtigen:

Open-Source-Modelle:

Open-Source-Modelle:

Können die bessere Wahl sein, wenn Transparenz und Sicherheit von hoher Bedeutung sind. Diese Modelle ermöglichen es Organisationen, das Modell mit ihren eigenen Daten zu optimieren und sicherzustellen, dass es sich entsprechend verhält.

Proprietäre Modelle:

Proprietäre Modelle:

Können die bessere Wahl sein, wenn Geschwindigkeit und allgemeine Vielseitigkeit (wie Multimodalität) am wichtigsten sind. Diese Modelle laufen oft in der Cloud und teilen nur begrenzte Details über ihre Trainingsdaten und wie sie die Daten einer Organisation verarbeiten. Proprietäre Modelle schneiden in der Regel nicht so gut ab wie angepasste Open-Source-Modelle, da viele verschiedene Domänen und nachgelagerte Aufgaben nicht ausreichend fein abgestimmt werden können.

Letztendlich sollten Organisationen sich mit KI-Experten beraten, um den am besten geeigneten Ansatz für ihre spezifischen Ziele und Anforderungen zu bestimmen.

KI-Modelle sind Entscheidungshilfen und das Automatisierungsniveau kann von Fall zu Fall definiert werden. Während KI viele Aufgaben automatisieren und wertvolle Einblicke liefern kann, ist es in einigen Fällen wichtig, dass menschliche Experten die Ergebnisse manuell überprüfen und validieren, um Genauigkeit und Compliance sicherzustellen. Beispielsweise kann ein LLM eine Banktransaktion als potenziell betrügerisch kennzeichnen. Ein menschlicher Analyst muss die gekennzeichnete Transaktion überprüfen, um festzustellen, ob sie tatsächlich betrügerisch ist oder ein Fehlalarm. Darüber hinaus muss ein menschlicher Experte Randfälle behandeln, die die KI möglicherweise nicht abdeckt.

G+D Netceteras KI-Lösungen sind mit Sicherheit und Compliance im Kern entworfen, um sicherzustellen, dass sensible Daten sicher bleiben. Unsere Experten arbeiten mit unseren Kunden zusammen, um ihre spezifischen Sicherheits- und Compliance-Bedürfnisse zu verstehen und KI-Lösungen zu implementieren, die den relevanten Vorschriften und Standards entsprechen.